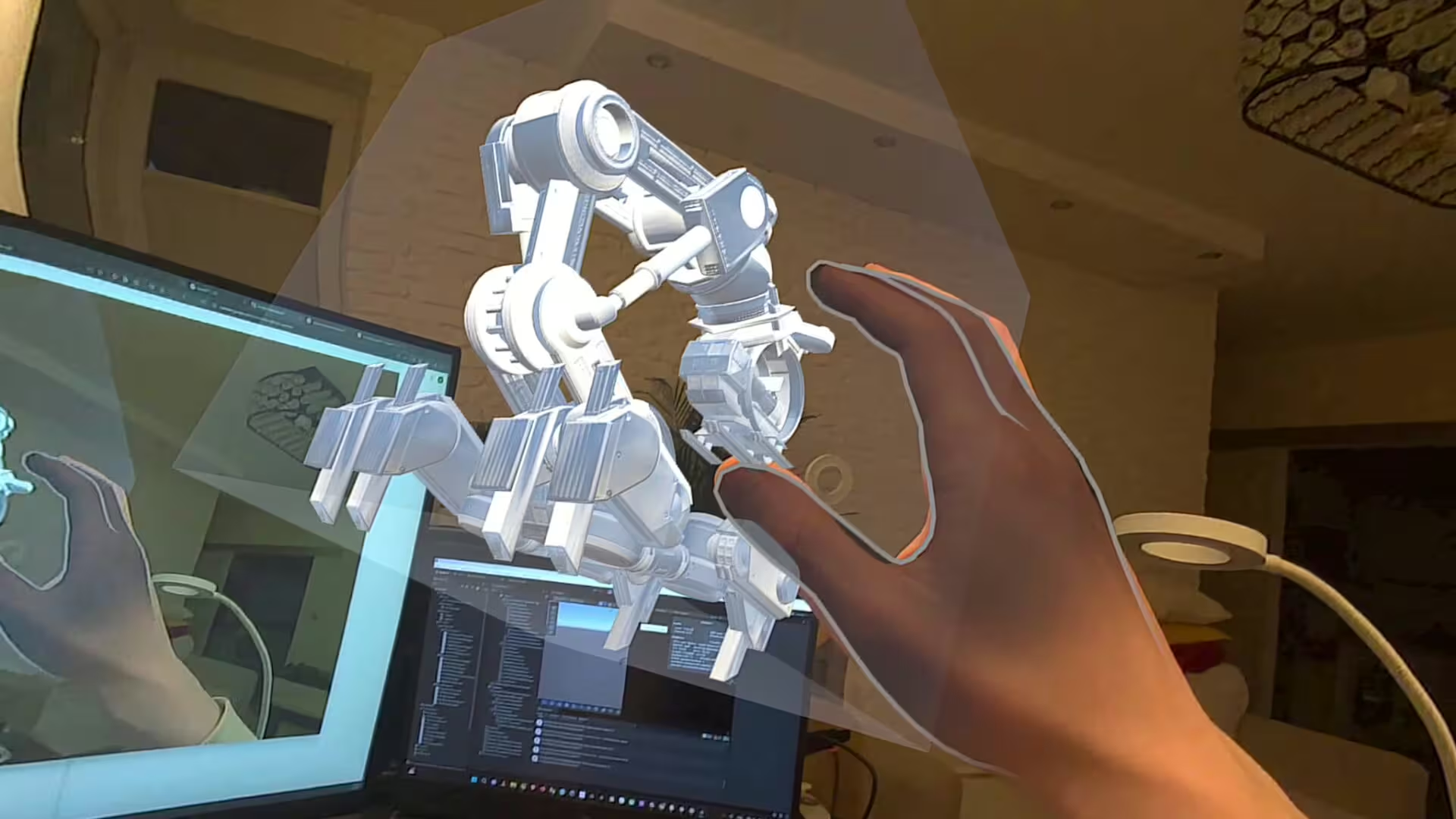

Celem pracy było opracowanie architektury i prototypu systemu integrującego platformę VisNow z rzeczywistością mieszaną (ang. Mixed Reality), umożliwiającego wyświetlanie i interakcję z trójwymiarowymi modelami naukowymi przy użyciu zestawu XR (Meta Quest 3). Projekt zakładał przeniesienie modeli z VisNow do aplikacji stworzonej w Unity, z naciskiem na naturalną interakcję (śledzenie ruchów dłoni oraz kontrolery), przestrzenną prezentację i niskie opóźnienia. Oznaczało to konieczność opracowania sposobu eksportu danych z VisNow w formacie zachowującym jak najwięcej informacji oraz zaprojektowania metod ich ponownego odwzorowania w środowisku Unity. W tym celu przygotowano modularny pipeline importu danych, dynamiczne skalowanie i pozycjonowanie modeli w przestrzeni XR (ang. extended reality) oraz system interakcji. Prototyp zweryfikowano w trybie PCVR (ang. computer-based virtual reality) z perspektywą dalszej migracji do trybu autonomicznego MR. W pracy zidentyfikowano kluczowe ograniczenia sprzętowe XR, przedstawiono potencjał integracji AI do obsługi poleceń głosowych oraz zaproponowano wieloetapową strategię rozwoju. Wyniki sugerują, że zastosowanie XR może wspierać analizę danych poprzez poprawę percepcji przestrzennej i uproszczenie interakcji.

The aim of this thesis was to develop the architecture and prototype of a system integrating the VisNow platform with Mixed Reality (MR), enabling the display and interaction with three-dimensional scientific models using an Extended Reality (XR) headset (Meta Quest 3). The project involved transferring models from VisNow to an application built in Unity, with a focus on natural interaction (hand tracking and controllers), spatial presentation, and low latency. This required designing a method for exporting data from VisNow in a format that preserves as much information as possible, along with developing techniques for accurately reconstructing the models within the Unity environment. To achieve this, a modular data import pipeline was created, along with dynamic scaling and positioning of models in XR space, and an interaction system. The prototype was validated in PCVR (computer-based virtual reality) mode, with a view toward future migration to standalone MR mode. The thesis identifies key hardware limitations of XR, presents the potential for integrating AI-based voice command support, and proposes a multi-stage development strategy. The results suggest that XR can enhance data analysis by improving spatial perception and simplifying interaction.